L’essor fulgurant de l’IA générative ouvre des possibilités incroyables. Mais pour dépasser le simple échange textuel et créer de véritables assistants capables d’agir, comprendre et interagir avec leur environnement, il faut plus qu’un modèle isolé.

Le Model Context Protocol (MCP) répond à ce besoin en fournissant une interface standard pour connecter un agent IA à des services, données et outils externes. On fait le point à travers ce guide complet pour comprendre ce protocole, son fonctionnement et ses cas d’usage. 🚀

Qu’est-ce que le protocole MCP ?

À l’origine du protocole MCP

L’idée du MCP (Model Context Protocol) émerge fin 2024, initiée par Anthropic.

Son objectif : standardiser la manière dont un modèle IA accède à des données externes, sans multiplier les intégrations spécifiques.

Depuis, OpenAI, Google DeepMind et d’autres acteurs majeurs soutiennent son adoption pour rendre les assistants IA plus utiles et reliés au monde réel.

Rôle du MCP : un connecteur unifié

Le MCP est un protocole ouvert qui définit comment un agent IA peut interagir avec des serveurs externes.

Il joue le rôle de pont entre IA et services externes.

Grâce au protocole MCP, il devient alors possible d’interagir, depuis votre agent IA, avec des outils métiers variés :

- CRM

- ERP

- Messagerie

- Bases de données

- APIs métier

- Fichiers locaux

- Services standardisation

- Etc.

Contrairement à une simple API, MCP fournit une interface commune pour que tout ce petit monde travaille ensemble de façon sécurisée et standardisée.

Cela permet d’utiliser l’IA comme un outil actif capable d’exécuter des actions concrètes, pas juste de générer du texte.

Un agent IA peut par exemple demander au serveur MCP :

- D’interroger une API météo

- D’envoyer un email via un service tiers

- De créer une facture dans une base de données

- Etc.

En bref, vous pouvez désormais demander à un agent IA compatible avec le serveur MCP de Gmail, comme par exemple Mistral : “Envoi un email à mon équipe avec le rapport de ventes joint”, et l’agent s’occupera de tout, en utilisant l’API Gmail. 🤯

Un agent IA peut identifier les outils accessibles via le MCP et décider :

- Quels serveurs solliciter (Gmail, Salesforce, etc.),

- Quelles actions réaliser (souvent via des appels API standardisés),

- Comment assembler les données pour générer une réponse, généralement en JSON.

Architecture MCP : host, client et serveur

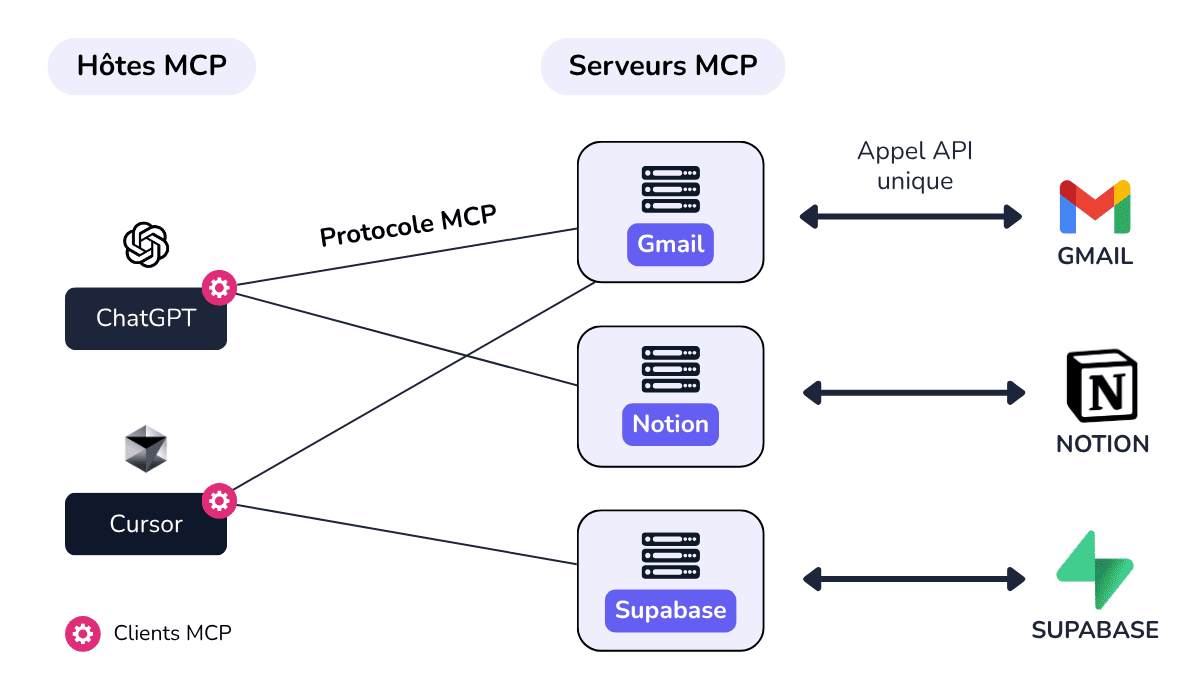

Le protocole MCP décrit 3 rôles principaux :

- Hôte MCP : L’application qui héberge ou initie une session MCP (ex. un IDE, une app desktop, un chatbot).

- Client MCP : Le connecteur (un script) qui sécurise et gère la communication entre l’hôte et le serveur MCP.

- Serveur MCP : Le point central qui implémente le protocole et fait le lien avec les systèmes tiers (APIs…).

Ce schéma met en lumière le fait que grâce au protocole MCP, il n’est plus nécessaire pour chaque client d’implémenter des intégrations spécifiques pour chaque service ou API.

Pour déclencher une action via Gmail, ChatGPT et Cursor n’auraient ici qu’à envoyer une requête au serveur MCP Gmail (sous la forme d’un objet JSON structuré), qui se charge de l’implémentation technique et de la communication avec les services externes.

Ce JSON est standardisé, il contient alors :

- Un contexte

- Des actions à exécuter

- Des métadonnées

Voici un exemple de requête JSON envoyée par un client MCP :

{

"sessionId": ...,

"context": {

...

},

"actions": [

...

]

}Workflow MCP typique :

- L’hôte MCP (ex. app, chatbot, IDE) envoie une requête via son client MCP.

- Le serveur MCP reçoit la requête et consulte le contexte (historique, variables…).

- Le serveur MCP appelle des API ou services externes (BD, CRM, plugins…).

- Le contexte est mis à jour si nécessaire et le serveur MCP peut mettre en mémoire ces données pour les prochaines requêtes.

- La réponse finale est renvoyée à l’hôte.

L’orchestration multi-agents

Le protocole MCP est un outil puissant, mais il ne gère pas tout seul la complexité des workflows multi-agents, à savoir une mémoire contextuelle partagée entre plusieurs LLM, ni l’orchestration des sous-tâches.

Si vous souhaitez travailler avec des agents IA variés (GPT-4, Claude, Mistral, etc.) ou des modèles spécialisés (traduction, résumé, analyse d’image…), il faut une approche plus globale.

C’est ce qu’on appelle l’orchestration multi-agents.

Pour cela, il faut implémenter ou intégrer une surcouche type orchestrateur (LangGraph, CrewAI ou infra maison), qui pourra alors :

- Router chaque sous-tâche vers le LLM ou l’agent IA le plus adapté,

- Synchroniser une mémoire contextuelle partagée (ex. Redis, vectordb)

Cette combinaison MCP + orchestrateur permet de créer des workflows agentiques puissants, tout en gardant une architecture modulaire.

Protocole MCP : cas d’usage

Imaginons que vous souhaitiez exploiter un agent IA pour analyser des candidatures, vérifier la disponibilité des candidats et synchroniser le tout avec votre calendrier de sessions d’entretiens.

- L’hôte MCP est l’agent IA (par exemple GPT-4). Son rôle est d’analyser et de synthétiser un CV et sa pertinence par rapport à une offre d’emploi (CV + offre d’emplois transmis en PJ).

- Ensuite, un appel API vérifie la disponibilité du candidat pour un entretien (via Google Calendar).

Voici un exemple de workflow complet avec le protocole MCP pour cette application RH :

1. Prompt + Upload des éléments de candidature

Le recruteur transmet le CV et l’offre d’emploi au LLM utilisé (GPT-4) via un appel API et lui demande de résumer le profil du candidat puis de lui donner un calcul de score de matching avec le poste à pourvoir :

{

"sessionId": "123456789",

"context": {

"candidate": {

"firstname": "Camille",

"lastname": "Sorrad",

"cv": "camille-cv.pdf",

}

}

}2. Traitement LLM

GPT-4 produit un résumé clair du profil candidat et analyse en détail les compétences, points forts, et le matching avec le poste. Il met à jour le contexzte avec les éléments suivants :

{

"summary": "Camille est une experte Python avec une forte expérience en Data Science...",

"highlights": ["Python avancé", "Projets ML réussis"],

"matching_score": 78

}3. Requête au serveur MCP : vérification de la dispo pour entretien

L’agent IA, après avoir reçu le résumé et le score de matching, souhaite maintenant vérifier la disponibilité du candidat pour un entretien. Il va pour cela utiliser le protocole MCP pour orchestrer cette tâche.

Il lance alors une requête au serveur MCP Google Calendar pour vérifier la disponibilité du candidat pour un entretien via l’API Google Calendar, en lui transmettant le contexte mis à jour :

{

"sessionId": "123456789",

"context": {

"candidate": {

"firstname": "Camille",

"lastname": "Sorrad",

"cv": "camille-cv.pdf",

"summary": "Camille est une experte Python avec une forte expérience en Data Science...",

"highlights": ["Python avancé", "Projets ML réussis"],

"matching_score": 78

}

},

"actions": [

{

"type": "availability_check",

"service": "Google Calendar",

"payload": {

"interview_slots": [

"2025-07-02T10:00:00+02:00",

"2025-07-02T15:00:00+02:00",

"2025-07-03T09:00:00+02:00"

],

}

}

]

}4. Réponse du serveur MCP

Le serveur MCP Google Calendar reçoit la requête et interroge l’API Google Calendar pour vérifier la disponibilité du candidat et met à jour le contexte avec les créneaux d’entretien possibles.

{

"sessionId": "123456789",

"context": {

"candidate": {

"firstname": "Camille",

"lastname": "Sorrad",

"cv": "camille-cv.pdf",

"summary": "Camille est une experte Python avec une forte expérience en Data Science...",

"highlights": ["Python avancé", "Projets ML réussis"],

"matching_score": 78,

"availabilities": ["2025-07-02T10:00:00+02:00", "2025-07-03T09:00:00+02:00"]

}

},

}Le serveur MCP renvoie ce contexte enrichi à l’application RH, à savoir :

- 📝 Le résumé du candidat

- 🎯 Le score de matching

- 💪 Les points forts

- 📅 Les créneaux d’entretien disponibles

Pourquoi adopter le MCP ?

Le MCP établit un cadre commun pour organiser les échanges et interactions entre agents et serveurs, ce qui simplifie l’intégration et l’évolution des systèmes.

Voici les principaux avantages du protocole MCP :

- Interopérabilité : chaque agent suit les mêmes règles.

- Contextualisation durable : aucune perte d’infos d’une tâche à l’autre.

- Intégration API fluide : appels aux services externes intégrés dans le protocole.

- Scalabilité : plug & play de nouveaux agents ou services sans réécrire l’archi.

Limites et défis du protocole MCP

Le Model Context Protocol (MCP) ouvre de nombreuses possibilités, mais plusieurs défis restent à relever pour garantir son adoption efficace et sécurisée. Parmi eux, la standardisation encore jeune, la sécurité des échanges de données sensibles, et les enjeux de performance liés à la gestion simultanée de multiples agents et API.

Normes et standardisation

MCP est un protocole encore jeune, en phase d’adoption.

Son cadre doit encore mûrir pour devenir une norme solide et largement reconnue, avec des spécifications complètes assurant une interopérabilité fiable entre différents acteurs et implémentations.

Sécurité

La protection des données dans un contexte partagé est cruciale.

Un serveur MCP doit intégrer des mécanismes robustes de contrôle d’accès et de gestion des permissions afin d’assurer que seules les entités autorisées peuvent lire ou modifier des données sensibles, ou invoquer des API spécifiques.

Cela permet d’éviter les fuites d’informations et de garantir la confidentialité tout au long du processus.

Performance

Orchestrer plusieurs agents IA et appels API externes peut générer des temps de latence importants, impactant l’expérience utilisateur.

Il est donc indispensable d’optimiser la gestion des requêtes, la parallélisation, et le caching des données pour assurer un fonctionnement fluide et scalable du protocole.

Vous l’aurez conpris, MCP est un protocole simple, modulaire et déjà supporté par les grands acteurs de l’IA. Il devient aujourd’hui incontournable pour construire des assistants IA qui vont au-delà du simple échange textuel : bienvenue dans l’ère des agents branchés à leurs outils métiers.

Pour aller plus loin (multi-LLM, workflows complexes, mémoire globale), je vous invite à creuser comment mettre en place un serveur MCP avec une orchestration agentique adaptée.